Bu gelişme, data merkezleri ve yapay zeka algoritmalarının performansını artırırken, daha karmaşık hesaplamaların daha kısa müddette yapılabilmesine imkan tanıyor.

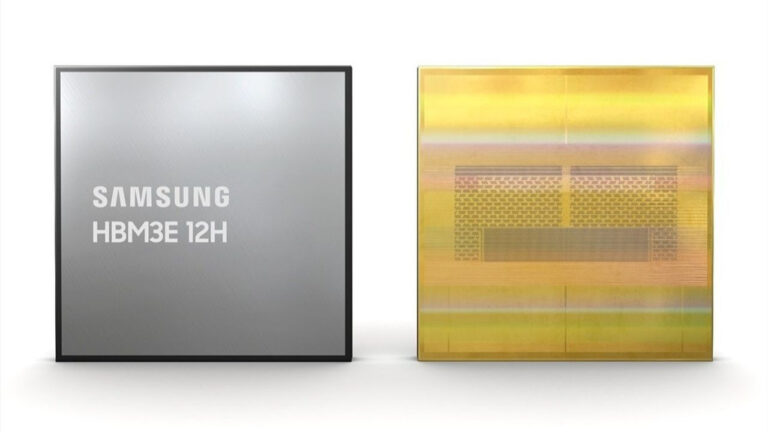

Samsung’un HBM3E 12H DRAM’ı ile yüksek bant genişliği belleği (HBM) alanında yeni bir periyot başlıyor. HBM, yüksek bant genişliğine gereksinim duyan uygulamalar için tasarlanmış bir bellek tipidir ve Samsung bu alanda kıymetli bir yenilik yapıyor. Ekim ayında, üçüncü jenerasyon HBM’nin geliştirilmiş bir versiyonu olan HBM3E Shinebolt’u tanıtan Samsung, bu teknolojiyle pin başına 9.8Gbps sürate ve tüm paket için 1.2 terabyte saniyelik bir bant genişliğine ulaştı.

12H, her modülde dikey olarak üst üste konulan çip sayısını söz ediyor. Bu durumda 12 çip bir ortaya getirilmiş. Bu metot, bir modülde daha fazla bellek sığdırmanın bir yolunu sunuyor ve Samsung 12H dizaynıyla 36GB kapasiteye, yani 8H dizaynına nazaran %50 daha fazla belleğe ulaşıyor. Bant genişliği ise 1.2 terabyte saniyede sabit kalıyor.

TC NCF ise Isıl Sıkıştırma İletken Olmayan Sinema manasına geliyor ve çipler ortasına yerleştirilen malzemeyi söz ediyor. Samsung, bu malzemeyi daha ince bir hale getirerek, artık 7µm kalınlığında bir yapıya indirdi. Böylelikle 12H yığınağı, 8H yığını ile tıpkı yükseklikte olabiliyor ve birebir HBM ambalajının kullanılmasına imkan tanıyor. TC NCF’nin bir öbür avantajı ise, ısı özelliklerini güzelleştirerek soğutmayı da geliştirmesi. Dahası, bu yeni HBM3E 12H DRAM’da kullanılan sistem, birebir vakitte verimliliği de artırıyor.

Samsung’un yapay zeka atılımı HBM3E bellek sunuyor

Peki, bu gelişmiş bellek teknolojisi nerede kullanılacak? Karşılık vermeye gerek yok; yapay zeka günümüzün en tanınan mevzularından biri. Sahiden de, yapay zeka üzere uygulamalar, yüksek ölçüde RAM gerektiriyor. Geçen yıl Nvidia, yüksek bant genişliği belleği tedarikçileri listesine Samsung’u ekledi ve şirket, tüketiciye yönelik grafik kartlarından çok daha yüksek performans sunan kimi inanılmaz dizaynlar geliştiriyor.

Örneğin, Nvidia’nın H200 Tensor Core GPU’su, toplamda 4.8 terabyte saniyelik bir sürate sahip 141GB HBM3E belleğe sahip. Bu, GDDR ile çalışan tüketiciye yönelik bir grafik kartından çok daha yüksektir. Örneğin, RTX 4090, yalnızca 1 terabyte saniyelik bir süratle 24GB GDDR6’ya sahip.

Raporlara nazaran, H200, toplamda 144GB olan lakin kullanılabilir haliyle 141GB olan altı adet 24GB HBM3E 8H modülü kullanıyor. Birebir kapasite, yalnızca dört 12H modülü ile sağlanabilirken; alternatif olarak, altı 12H modülü ile 216GB kapasiteye ulaşılabilir.

Samsung’un iddialarına nazaran, yeni 12H dizaynının ek kapasitesi, yapay zeka eğitimini %34 hızlandıracak ve çıkarım hizmetlerinin “11,5 kat daha fazla” kullanıcıyı yönetim etmesine imkan tanıyacak.

Yapay zeka patlaması, H200 üzere hızlandırıcıları yüksek talepte tutacak, böylelikle bellek tedarikçisi olmak kârlı bir iş haline geliyor. Bu nedenle Micron, Samsung ve SK Hynix üzere şirketlerin bu pastadan bir hisse almak istemeleri şaşırtan değil.